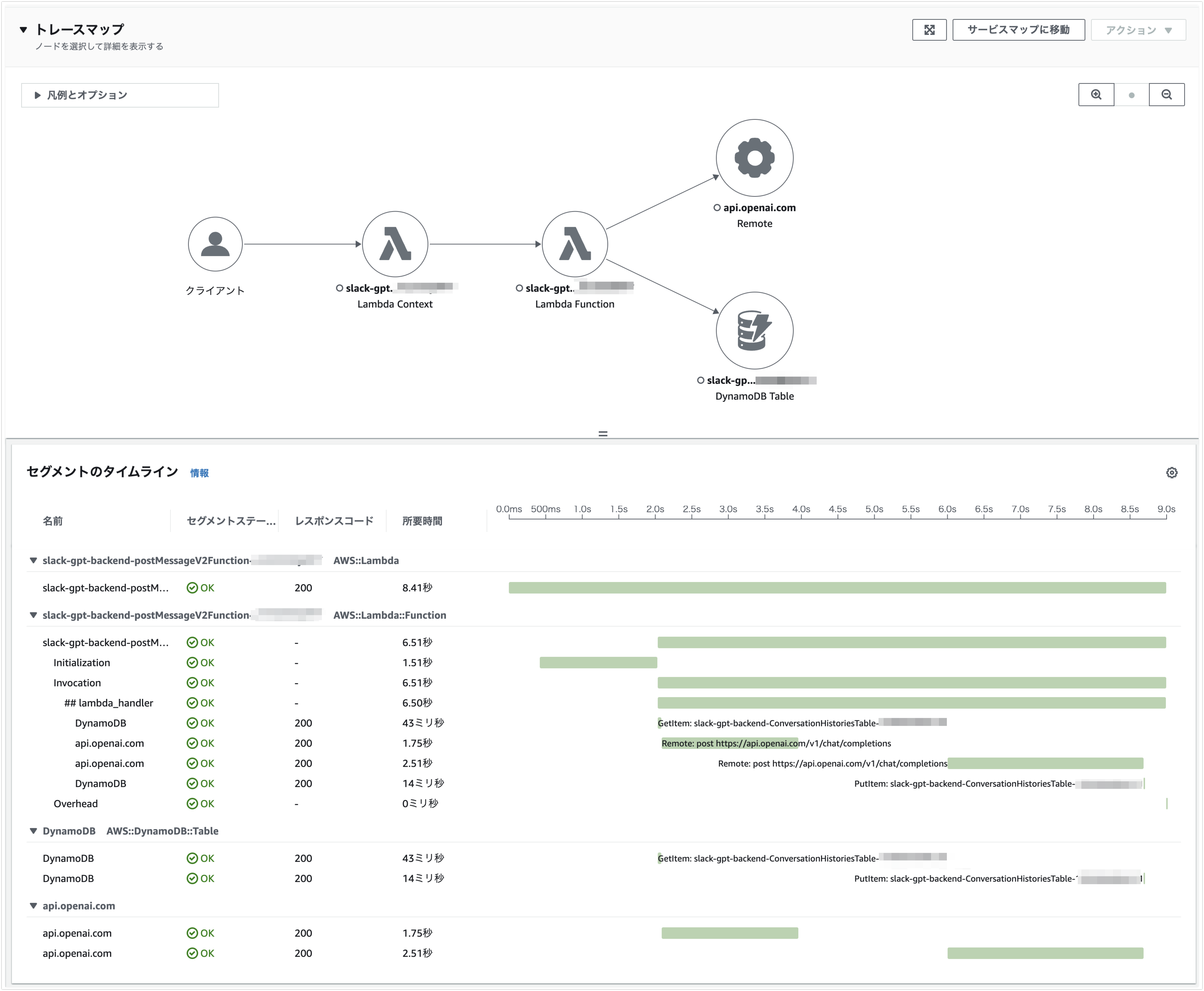

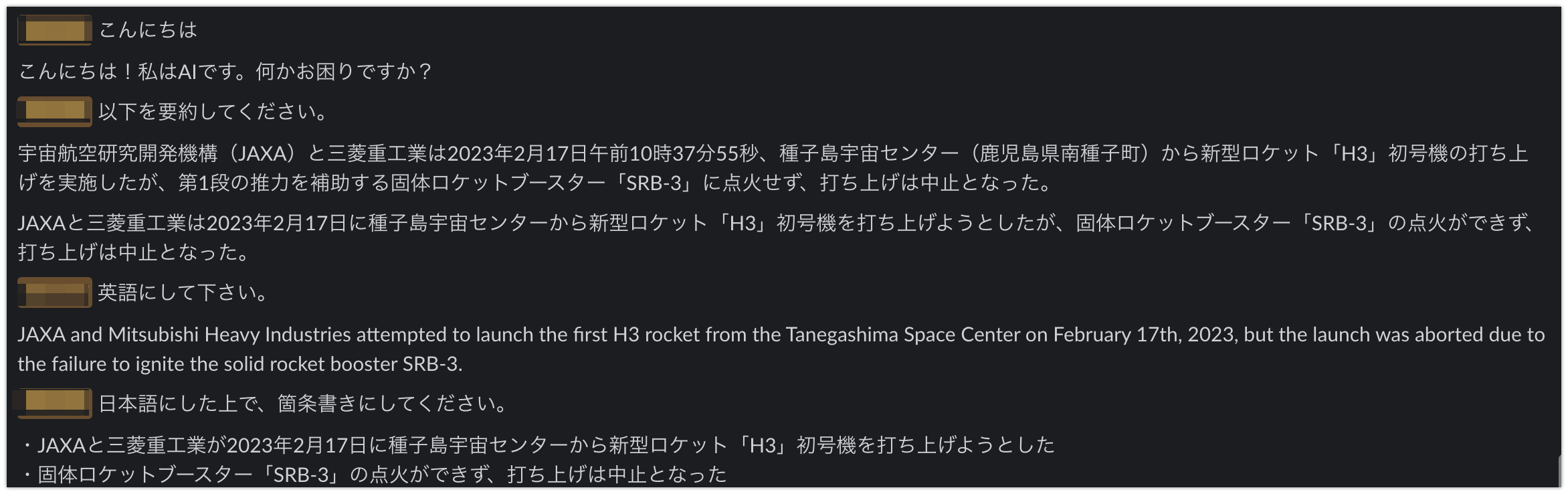

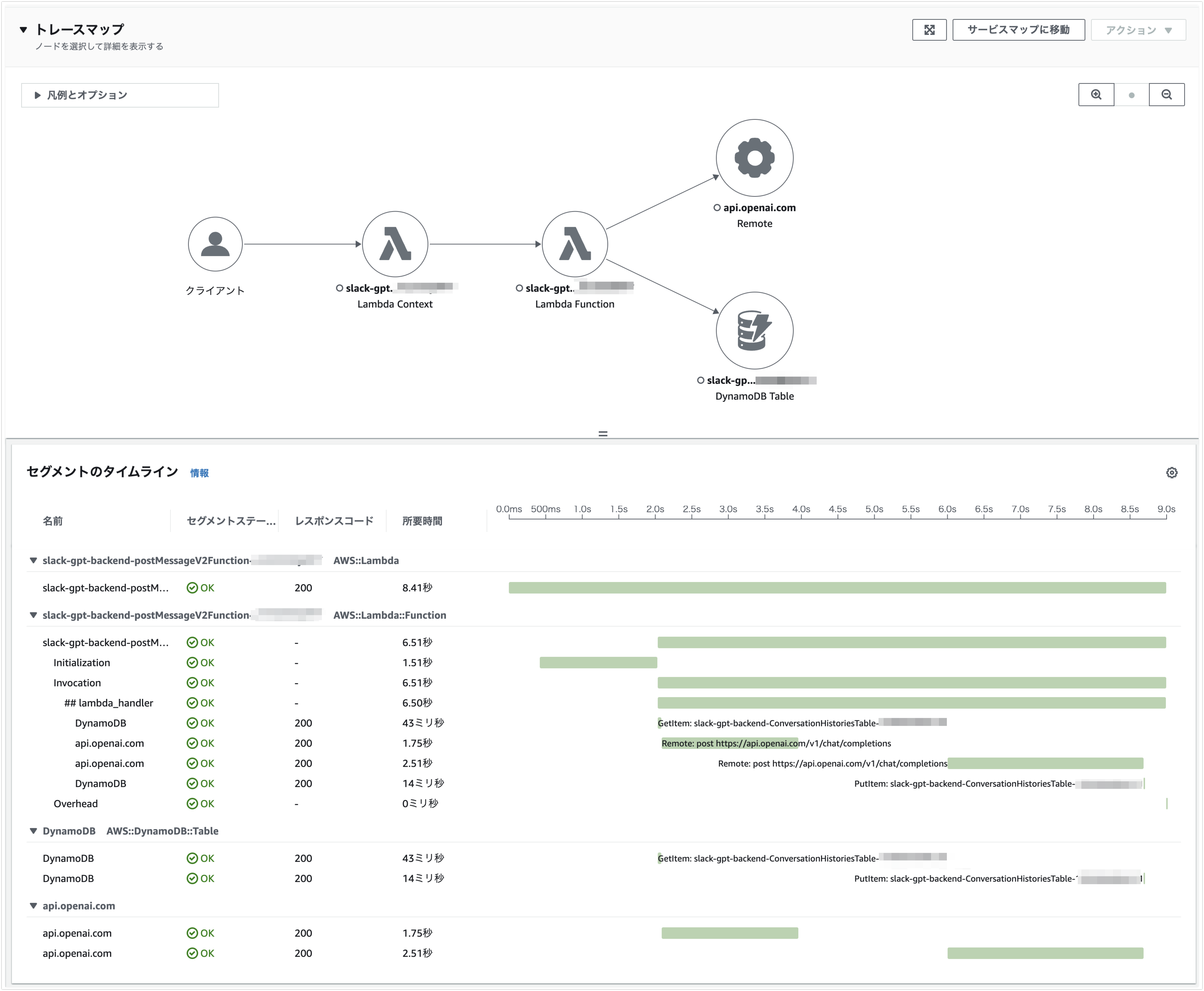

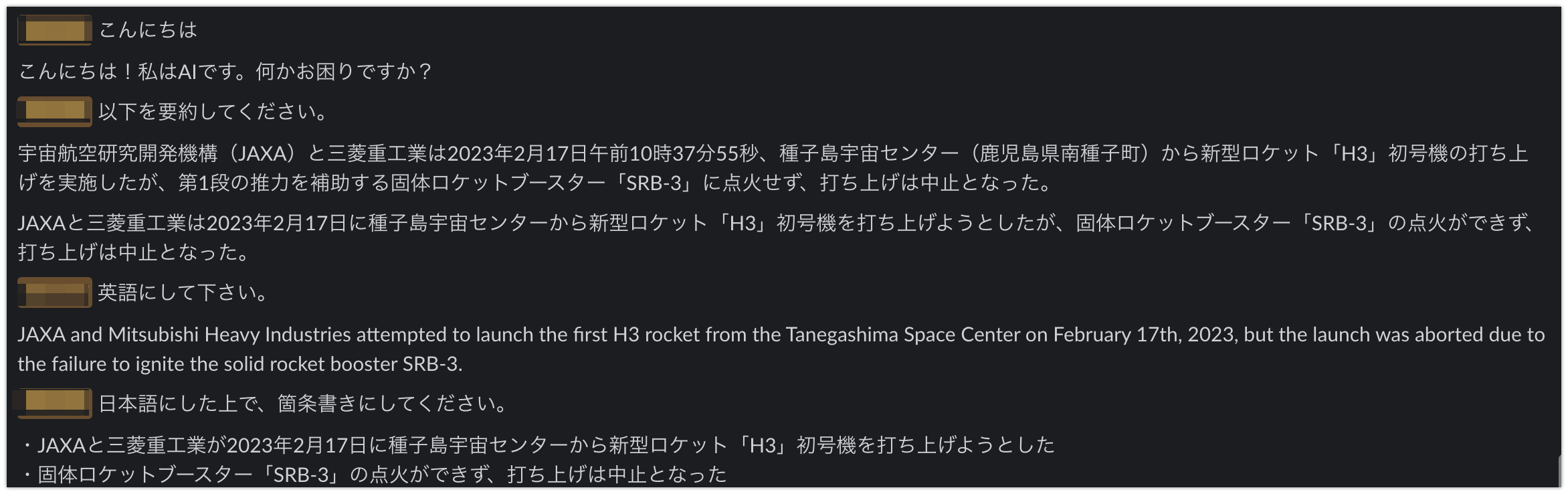

LangChain と OpenAI API を使って Slack 用のチャットボットをサーバーレスで作ってみる(ChatGPT 編) TL;DR OpenAI API で利用できるモデルとして、ChatGPT(Plus)と同様のモデルであるgpt-3.5-turboが利用できるようになったので、前回のLangChain と OpenAI API を使って Slack 用のチャットボットをサーバーレスで作ってみると同じようにサーバーレスで Slack 用チャットボットを実装してみました。

LangChain と OpenAI API を使って Slack 用のチャットボットをサーバーレスで作ってみる TL;DR LangChainを使って Slack 用のチャットボットを作ってみました。AI/ML モデルは OpenAI API(text-davinci-003)を利用しています。LangChain の Memory 機能を利用しており、会話の履歴も考慮して返信することができます。この際、OpenAI 側のモデルの入力トークン制限が問題になりますが、ConversationSummaryBufferMemoryを利用することで、一定のトークン数を超える履歴は要約して保持するようになっています。

Gradioを使った機械学習モデルのデモンストレーションをAWS App Runnerでサービスする TL;DR Gradioを利用すると機械学習モデルをデモンストレーションするためのWebアプリを簡単に作成することが可能です。Gradioを利用したWebアプリを他の人に使ってもらう方法として、クラウド上にデプロイすることが考えられますが、比較的安価かつ簡単にデプロイする環境としてAWS App Runnerを使ってみました。

GitHub Actions + Hugo + AWS S3 + CloudFrontでホームページをリニューアルしました TL;DR www.inoue-kobo.comは静的サイトジェネレータにより生成しています。今まではMkDocsで運用していたのですが、Hugoに乗り換えてみました。ついでにCI/CDパイプラインをAWS CodeBuildからGitHub Actionsに変更しています。

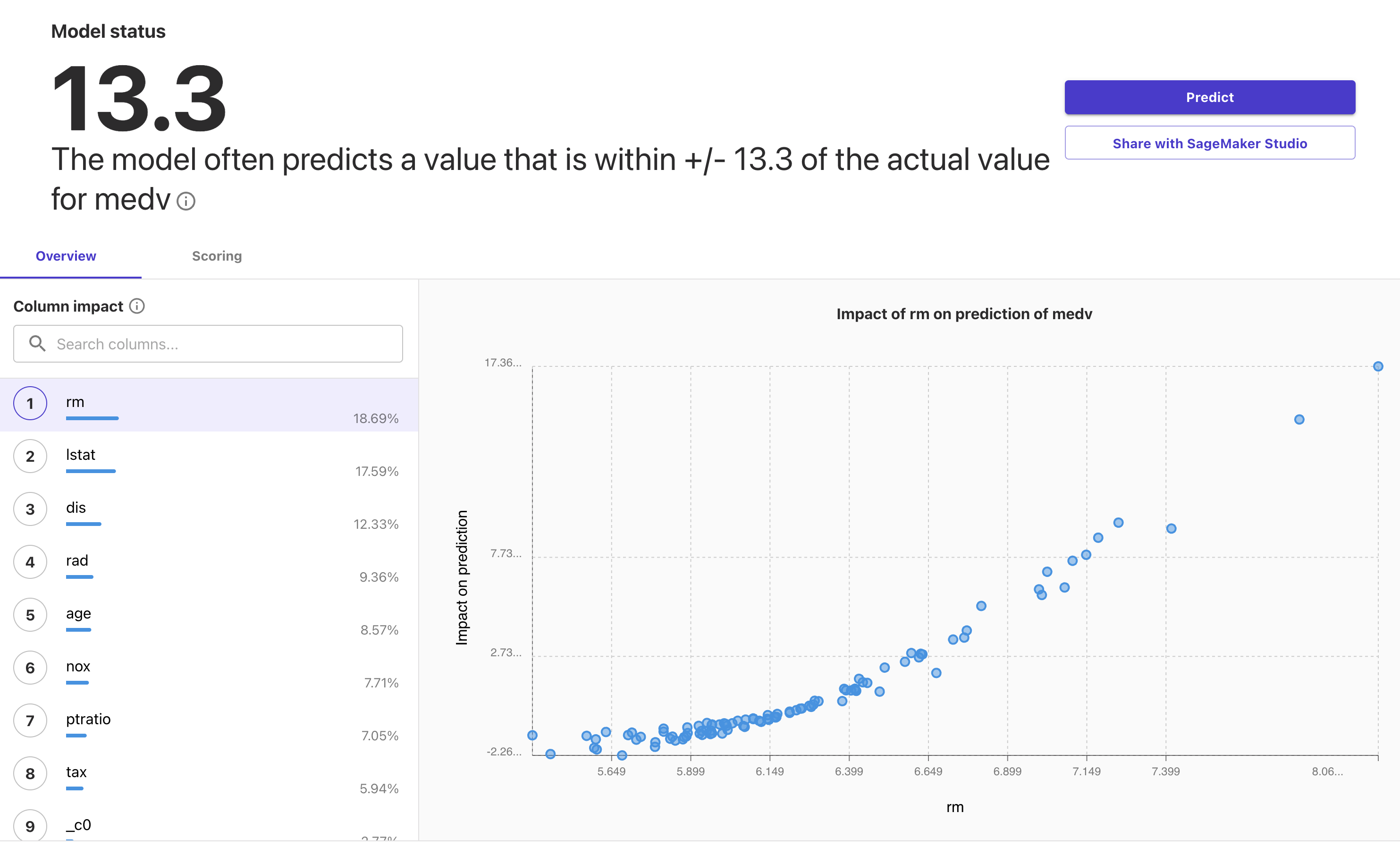

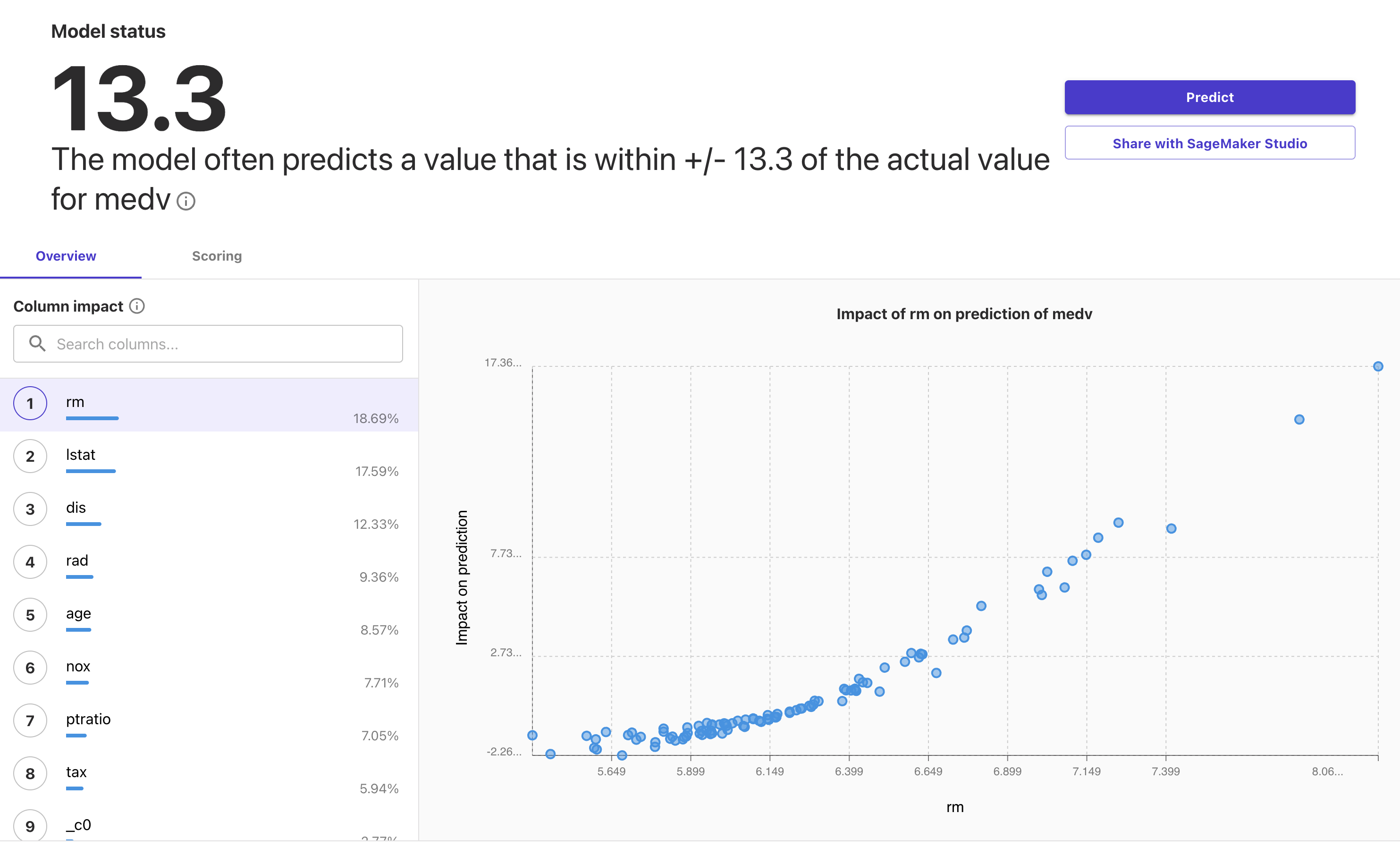

SageMaker Canvasを使ってみた TL;DR AWS re:Invent 2021でSageMakerの新機能であるSageMaker Canvasが発表されました。GUIで操作を完結できるテーブルデータに対するAutoMLサービスです。

SageMakerで利用できるDeepChemのためDockerfile TL;DR SageMakerでトレーニングのために使用できるDeepChem用のDockerfileです。 バージョン依存にするため、取り急ぎ以下のバージョン専用です。

deepchem-2.3.0 python-3.6 tensorflow-1.14.0 Dockerfileにより独自コンテナでSageMaker上でトレーニングする方法はSageMakerで独自コンテナでトレーニングする方法を参照してください。

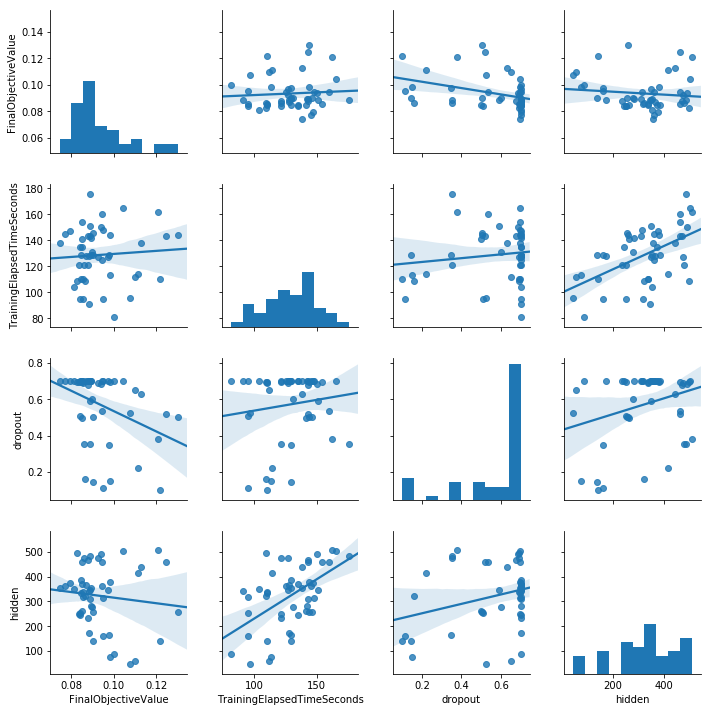

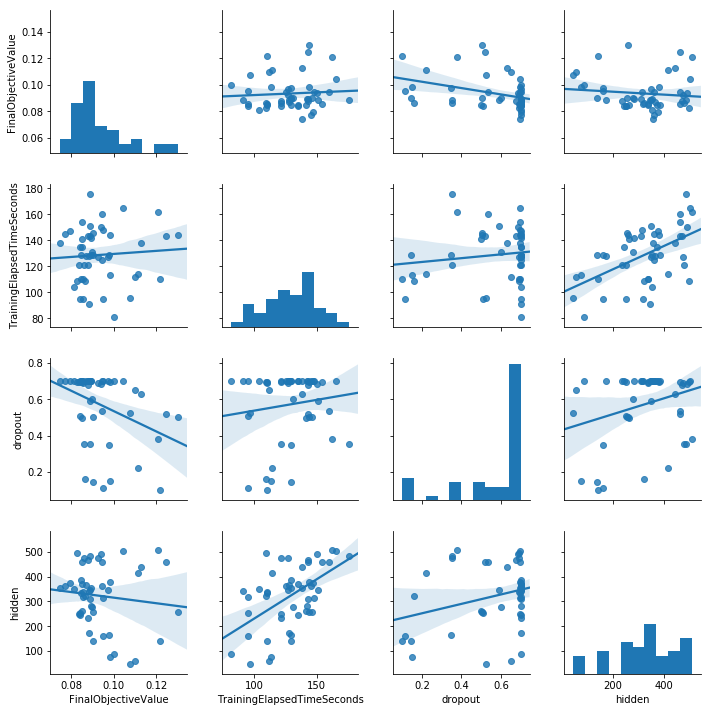

SageMakerで独自コンテナでトレーニングする方法 TL;DR AWS SageMakerで独自コンテナでトレーニングする方法です。 メトリクスの設定などを含めて必要最小限の設定でトレーニングするためのサンプルとなります。 ローカルモードとSageMaker上のトレーニングジョブとしての実行もフラグの切替で可能となっています。

AWS DeepLens Tips TL;DR AWS DeepLensがやっと届いたので動かしてました。 挙動を掴むまで結構ハマったので、注意点とか確認方法などのTipsを纏めてみました。

SageMakerでKerasの独自モデルをトレーニングしてデプロイするまで(Python3対応) TL;DR AWS SageMakerにおいて、Kerasによる独自モデルをトレーニングし、SageMakerのエンドポイントとしてデプロイします。 また、形態素解析やベクトル化のような前処理を、個別にDockerコンテナを作成することなしにエンドポイント内で行うようにします。このために、SageMaker TensorFlow Serving Containerを利用します。

SageMakerでTensorFlow+Kerasによる独自モデルをトレーニングする方法 TL;DR AWS SageMakerにおいて、TensorFlow+Kerasで作成した独自モデルをScript Modeのトレーニングジョブとして実行します。 トレーニングジョブ用のDockerイメージについてはSageMakerが提供するイメージをそのまま利用します。このため、独自のイメージをビルドする必要はありません。