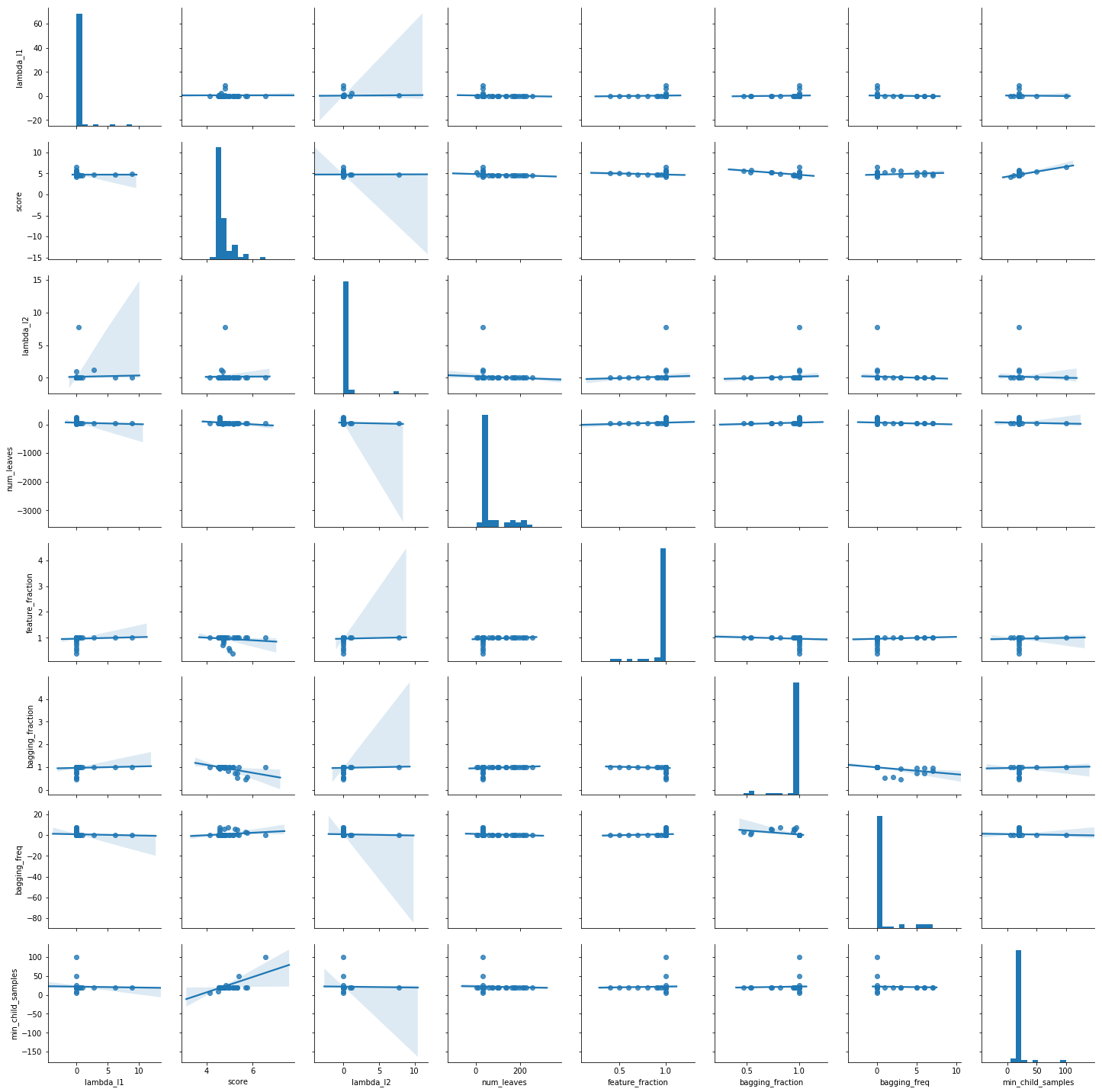

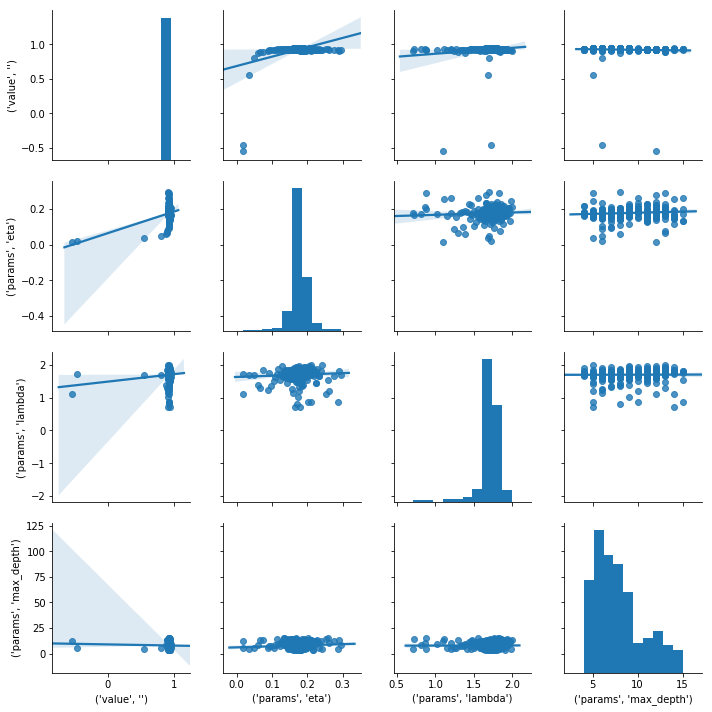

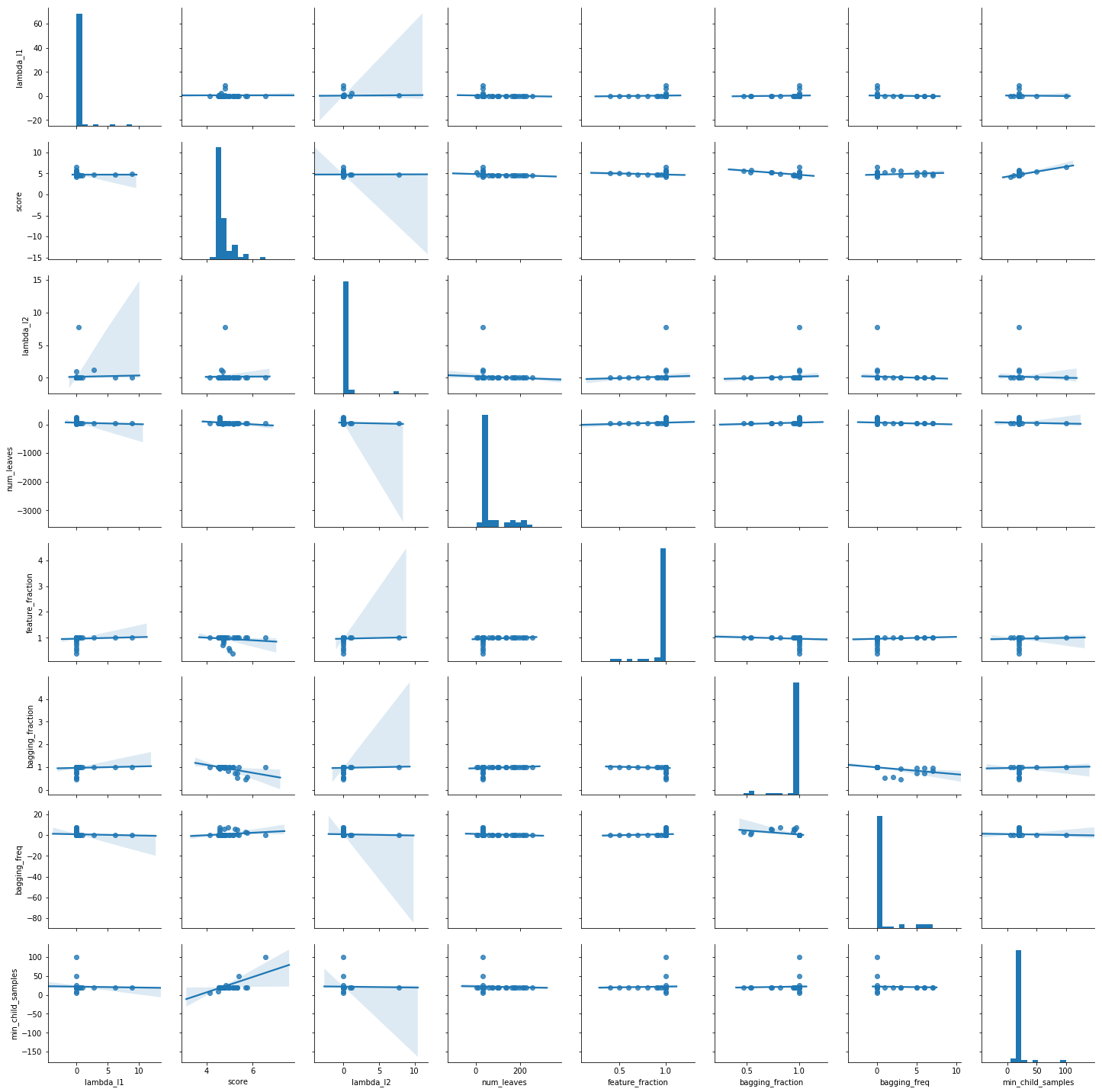

LightGBMをOptunaでパラメータチューニングする TL;DR LightGBMのパラメータをOptunaのLightGBM Tunerでチューニングします。 OptunaのLightGBM TunerはOptunaに組み込まれているLightGBM用のパラメータチューナーです。

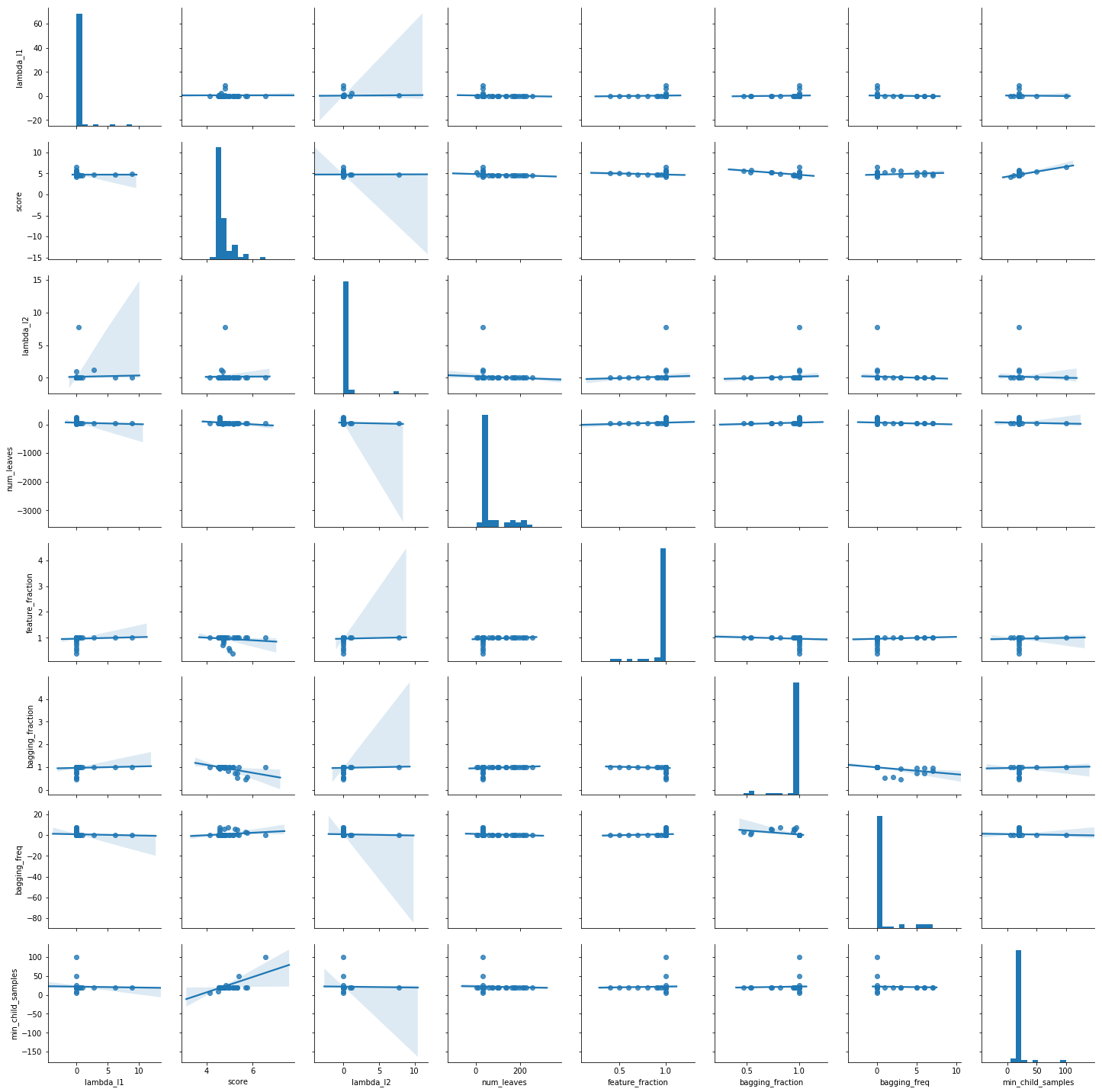

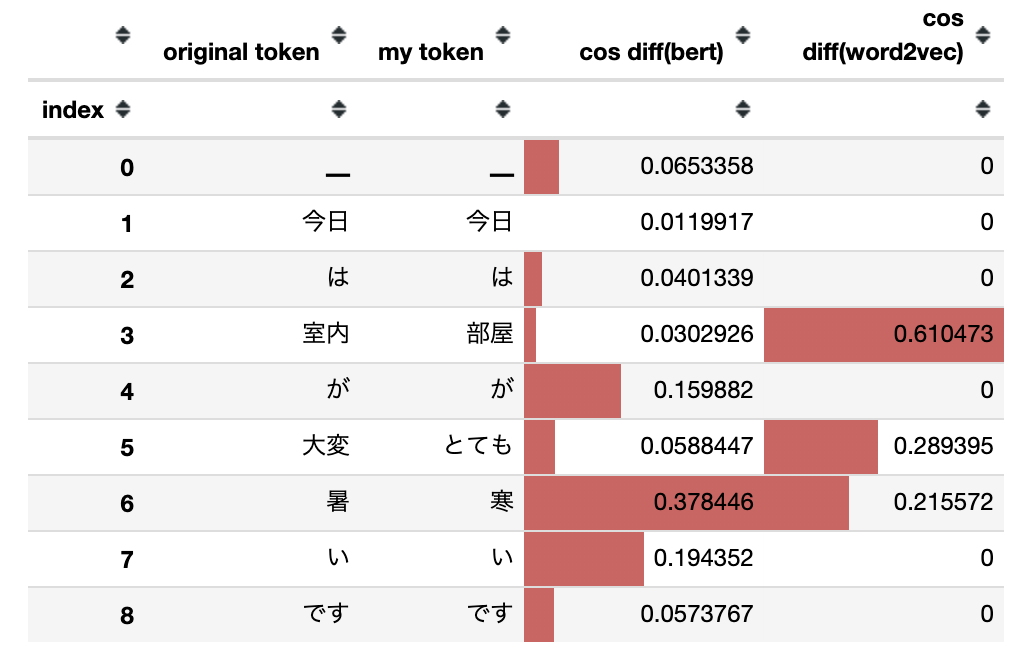

BERTおよびWord2Vecで文の類似性を確認する TL;DR 文の類似性を確認する方法としてBERTとWord2Vecを比較します。 文全体の類似性ではなくトークン単位での比較です。

BERTとWord2Vecによるベクトル化にはtext-vectorianを使用します。

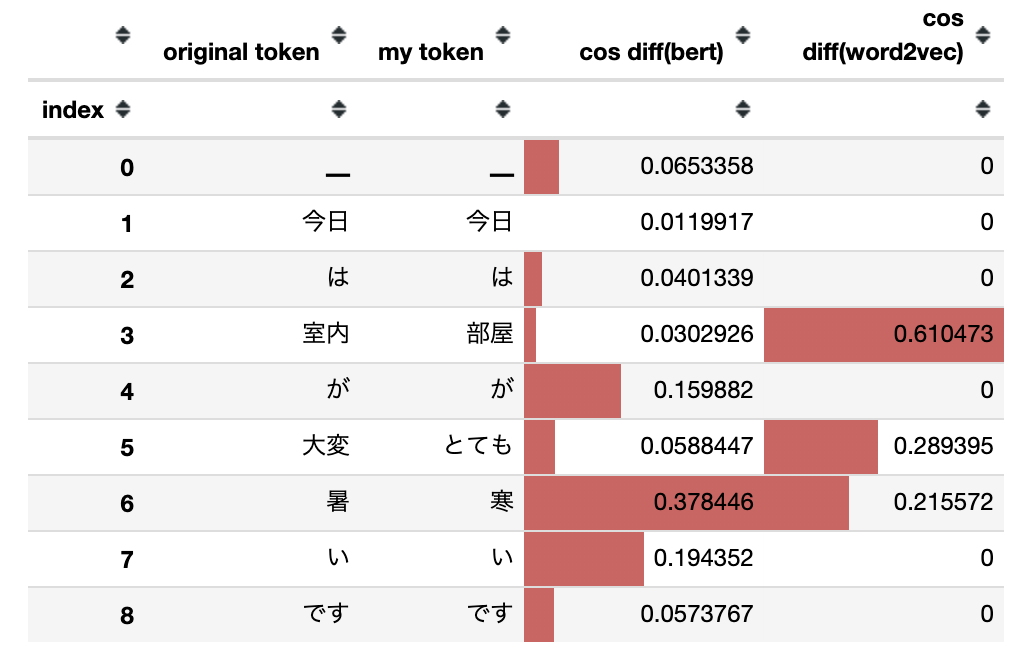

XGBoostをOptunaでパラメータチューニングする TL;DR XGBoostのパラメータをOptunaでチューニングします。 ベンチマーク用データとしてはボストン住宅価格データセットを使用します。

データ準備 scikit-learnのdatasetsを使ってデータをロードします。 学習データとテストデータの分割は8:2です。

もっと簡単に Keras BERT でファインチューニングしてみる TL;DR text-vectorianをバージョンアップし、BERT のファインチューニングで役に立つ機能を追加しました。

OpenAI Gym API for Fighting ICEを動かしてみる TL;DR Qiitaの方でコメントを頂いたので、早速gym-fightingiceを試してみました。

Keras BERTでファインチューニングしてみる TL;DR SentencePiece + 日本語WikipediaのBERTモデルをKeras BERTで利用するにおいて、Keras BERTを利用して日本語データセットの分類問題を扱って見ましたが、今回はファインチューニングを行ってみました。

SentencePiece + 日本語WikipediaのBERTモデルをKeras BERTで利用する TL;DR Googleが公開しているBERTの学習済みモデルは、日本語Wikipediaもデータセットに含まれていますが、Tokenizeの方法が分かち書きを前提としているため、そのまま利用しても日本語の分類問題ではあまり高い精度を得ることができません。

sumyを使って青空文庫を要約してみる TL;DR テキスト要約モジュールであるsumyを使って青空文庫の書籍を要約してみました。

sumyを使う部分はけ日記 - Python: LexRankで日本語の記事を要約するを参考にさせていただきました。 同記事ではTokenizerにJanomeを使用していますが、今回はginza(spacy)を使用しています。

Fighting ICEを動かしてみる TL;DR 格闘ゲームを題材にAIによるゲーム操作を試してみることができるFighting ICEを動かしてみました。 強化学習を利用すると面白いところですが、今回はとりあえず動かしてみるというところまでです。

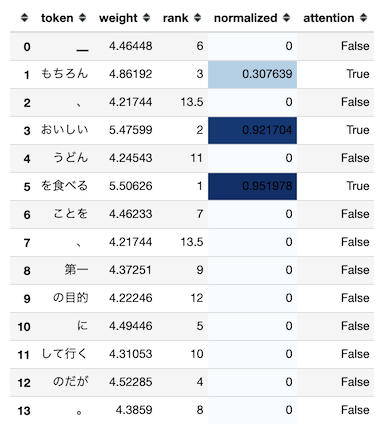

自然言語処理で使われるAttentionのWeightを可視化する TL;DR 自然言語処理で使われるAtentionのAttention Weight(Attention Weightを加味した入力シーケンス毎の出力)を可視化します。 これにより、モデルが推論を行った際に入力のどこに注目していたのかをユーザに表示することが可能です。